La palabra hardware proviene del inglés, y es un vocablo que ha surgido de la unión entre hard (duro) y ware (cosas, mercancía, artículo). Su significado hace alusión a todo el conjunto de aparatos físicos, tangibles, de un ordenador o computadora. Es importante destacar que este concepto no se traduce de un idioma a otro, sino que siempre se utiliza en inglés (al igual que su contraparte software).

Si bien hoy el empleo de computadoras, notebooks y demás dispositivos electrónicos es un elemento común en nuestra vida cotidiana, su surgimiento se remonta a mediados del siglo XX. En este artículo te contaremos qué tipo de hardware ha existido en la Historia, y cuáles son las distintas clasificaciones actuales; además, te describiremos todas las clases de hardware útiles. ¡Comencemos!

Índice de temas

Historia del desarrollo del hardware: el primer dispositivo de cálculo.

El surgimiento de métodos para hacer cálculos no es algo exclusivo del siglo XX: ya desde la Antigüedad se registran dispositivos como el mecanismo de Antikythera (Anticitera en español), calculadora mediante la cual se determinaba la posición de la Luna, el Sol y de los planetas. Este dispositivo funcionaba gracias a un complejísimo mecanismo de engranajes con el que se “seguía” el movimiento de los planetas. Su descubrimiento tuvo lugar hacia 1902, cuando un grupo de investigadores quedó atrapado en una isla griega (Anticitera, la que da el nombre al objeto) y, en la búsqueda de refugio, encontraron una galera romana, o antiguo barco de guerra, que en su interior tenía este elemento. Se cree que data, por lo menos, del 87 a.C.

Lo sorprendente de este aparato es lo sofisticado de su construcción: muchos investigadores coinciden en que se pensaba que tal nivel de avance en esa época era impensado.

Siglo XX: las cuatro generaciones.

Más acá en el tiempo, encontraremos cuatro etapas o generaciones del hardware, características ya que, entre una y otra, hay profundos cambios.

Primera generación: 1945-1956.

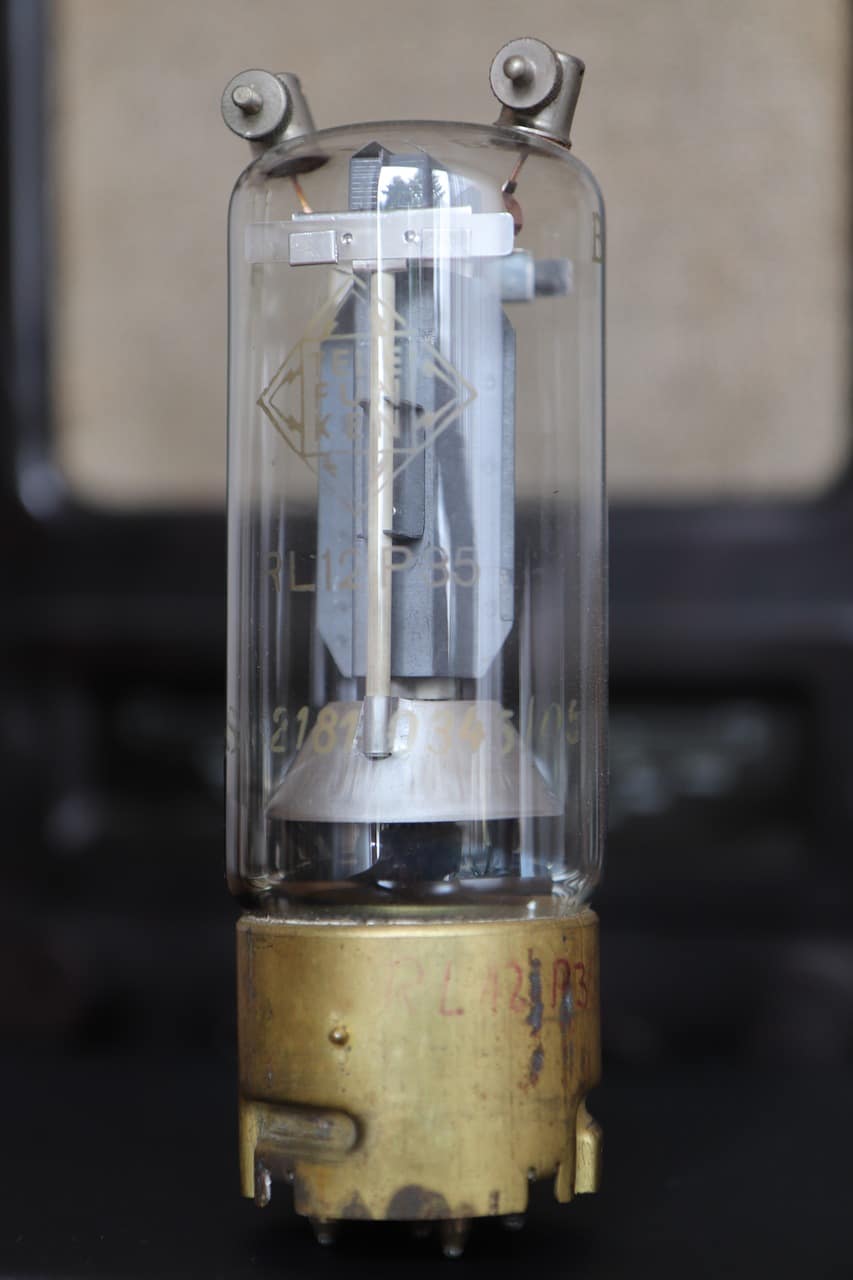

En esta época, los ordenadores tenían diferentes programas con un lenguaje distinto entre uno y uno. Cada instrucción que se le daba a este ordenador era para que realizase una tarea particular. La forma de almacenar datos era mediante tubos de vacío, unos bulbos cuyo tamaño no no superaba un foco de luz y permitía, por ejemplo, multiplicar números de hasta 10 dígitos en 25 milisegundos. La primera computadora que se crea con este sistema era para uso más bien comercial. Las computadoras de este período eran también muy grandes, demasiado costosas y, de igual modo, mucho más lentas.

Segunda generación: 1957-1963.

Esta etapa se ubica en la Segunda Guerra Mundial. Cuenta, en primer lugar, con una reducción en el tamaño y valor económico. Empiezan a surgir varias compañías que las generaban, y, a diferencia de la etapa anterior, contaban con transistores (del inglés transistor resistor, resistor de transferencia) para el procesamiento de la información.

Estos transistores, de menor tamaño que los tubos de vacío, podían almacenarse de a mucha más cantidad y en el mismo espacio que un solo tubo.

Los programas de computación de la anterior etapa fueron mejorados gracias a este sistema, y surgen otros lenguajes de programación que eran habilitados para uso comercial.

Mencionamos que su tamaño disminuye, y sus usos se amplían: gracias a este sistema, la Marina estadounidense produce el primer simulador de vuelos, por lo que empezamos a ver cómo se perfeccionan las computadoras.

Tercera generación: 1964-1971.

Estas computadoras eran mucho más pequeñas que las anteriores: generaban menos calor y también se había optimizado su velocidad, por lo que funcionaban cada vez más rápido.

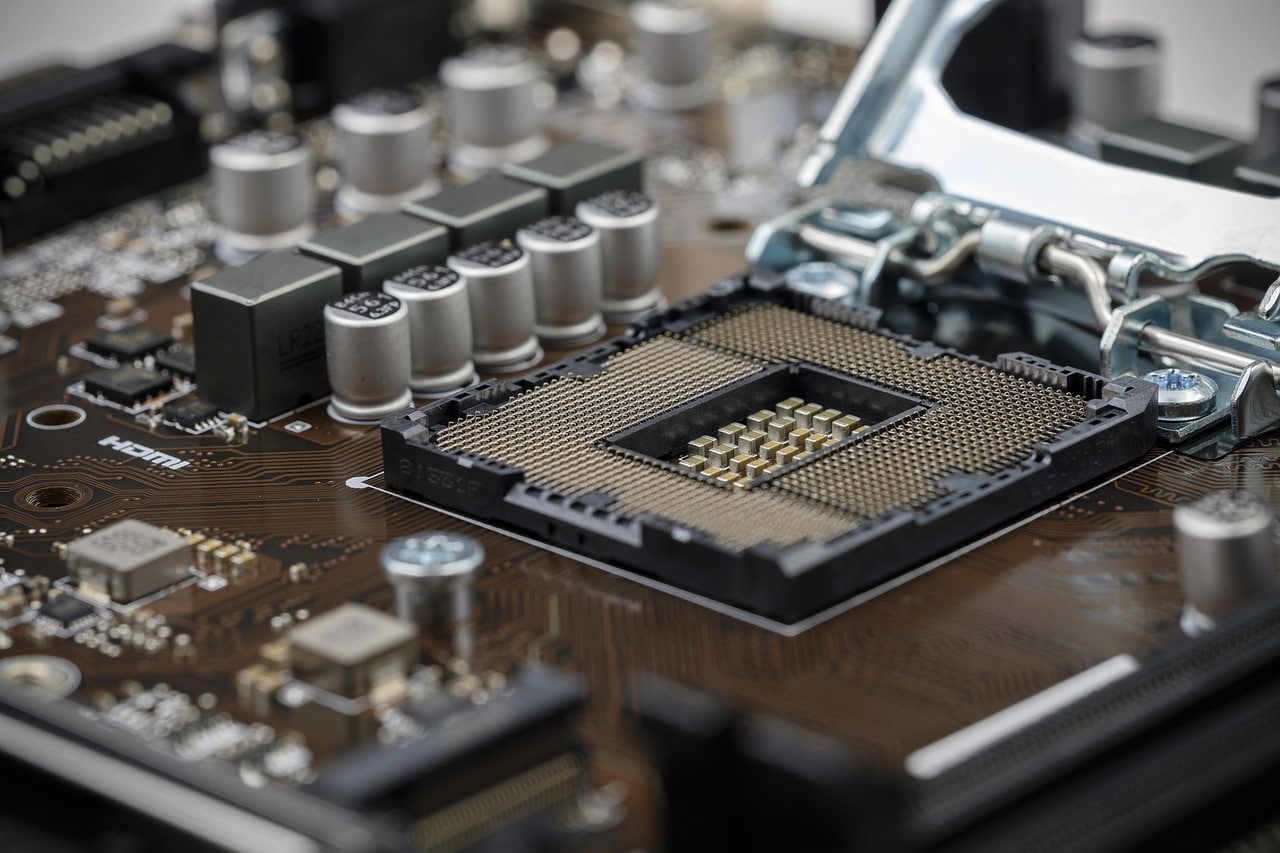

En esta etapa el descubrimiento fundamental es el uso de pastillas de silicio para la conformación de circuitos integrados. Esto permitió que se colocasen muchísimos más transistores en un circuito que se imprimía en tal pastilla (es el incipiente chip): gracias a esto se optimizan las características mencionadas de menos calor, más velocidad y menos costo.

Una de las computadoras claves de esta época es la IBM 360, la primera computadora comercial con circuito integrado. Además del procesamiento numérico como las anteriores, ya empezaba a permitir procesamiento de archivos, y podía contener terminales remotos que permitían ingresar a la computadora madre para procesar tales archivos en un banco de datos, por ejemplo, extrayéndolos o introduciéndolos.

Esta es la etapa, también, en la que el software como industria empieza a desarrollarse, ya que hay una conformación de programas de alto nivel y rendimiento.

Cuarta generación: 1971-1988.

El elemento crucial de este período es el microprocesador, circuitos integrados cuya velocidad no había sido antes registrada, gracias a que se optimiza aún más el uso de pastillas de silicio que se integran a mayor escala.

La “portabilidad” que empieza a surgir en la etapa anterior (al irse reduciendo el tamaño de los ordenadores) permitirá que en este momento surjan las computadoras personales o PC.

Partes del hardware.

Así como hemos visto diferentes etapas, también hay múltiples clasificaciones para el hardware.

Una división hecha sobre la base de los elementos fundamentales para el funcionamiento es la siguiente:

- Hardware básico: son los componentes esenciales de un ordenador, sin los cuales no funciona correctamente. Encontramos aquí el motherboard o placa madre (tarjeta de circuito impreso desde donde se conectan los demás componentes del hardware); también el mouse, el monitor, el teclado, la memoria RAM (donde se almacenan los programas o el software y los datos que el CPU procesa) y el CPU.

- Hardware complementario: los elementos que complementan las funciones del hardware básico. No son primordiales, pero sí tienen alta utilidad. En este grupo tenemos pendrives, impresoras y escáners, cámaras de video, etcétera.

A su vez, este grupo de elementos se puede clasificar en relación con su funcionamiento interno:

Hardware periférico.

- de entrada: Permiten el ingreso de información o datos al ordenador. Teclado, mouse, escáner, etcétera.

- de salida: Gracias a ellos, se reproducen los datos de la computadora. Un ejemplo es el monitor, pero también los auriculares (salida de sonido) o parlantes, y la impresora.

- de entrada y salida: Este hardware mixto recibe información del exterior pero también da la posibilidad de procesarla y enviarla por fuera del ordenador. Aquí encontraremos el uso del disco duro (puede guardarse información de la computadora pero también extraer archivos y transportarlos a otro equipo, o ser simplemente una base para guardarlos) y, en menos escala, un pendrive o una cámara web (pueden tomarse fotos y almacenar el material).

- Hardware de almacenamiento: Brinda la opción de almacenar los datos, información, archivos, y todo aquel elemento que se desee guardar en el ordenador. La principal fuente de almacenamiento es la memoria RAM (o Random Access Memory, que almacena datos a corto plazo y a los que se tiene fácil acceso), pero también un disco sólido o SDD, un disco duro y, actualmente (y cada vez más extendido), el almacenamiento en la nube.

- Hardware de procesamiento: aquí encontramos el CPU, siglas del inglés Central Processing Unit (Unidad Central de Procesamiento). Es lo que consideraríamos el “cerebro” de nuestro ordenador: procesa los datos, hace cálculos, recolecta información y la decodifica o procesa en partes más pequeñas. Es, asimismo, denominado como microprocesador: hoy en día, mientras más poderoso sea, más rápido hará funcionar el ordenador, pero también lo hará trabajar mucho más rápido y eficientemente.

Citar este artículo

Fernández, A. M. (21 de diciembre de 2021). Definición de hardware. Historia, orígenes y tipos. Definicion.com. https://definicion.com/hardware/